keeppassion什么意思_vmess和ss区别

Hi,大家好,我是编程小6,很荣幸遇见你,我把这些年在开发过程中遇到的问题或想法写出来,今天说一说

keeppassion什么意思_vmess和ss区别,希望能够帮助你!!!。

文章目录

- 一、Keepalived 概述

-

-

- 1. 为什么需要 keepalived

- 2. keepalived 是什么

- 3. keepalived 服务重要功能

- 4. keepalived 高可用故障切换转移原理

- 5. keepalived 体系主要模块及其作用

- 6. 使用 keepalived 实现双机热备

-

- 二、LVS + DR + Keepalived 高可用集群构建

-

-

- 1. 集群概述

- 3. 案例配置

- 4. 正式部署

-

一、Keepalived 概述

1. 为什么需要 keepalived

企业应用中,单台服务器承担应用存在单点故障的危险,单点故障一旦发生,企业服务将发生中断,造成极大的危害和损失。

2. keepalived 是什么

keepalived 软件起初是专为 LVS 负载均衡软件设计的,用来管理并监控 LVS 集群中各个服务节点的状态,后来又加入了可以实现高可用的 VRRP 功能。因此,keepalived 除了能够管理 LVS 集群外,还可以为其他服务(例如:Nginx、Haproxy、MySQL等)实现高可用。

keepalived 软件主要是通过 VRRP 协议实现高可用功能的。VRRP 是 Virtual Router Redundancy Protocol(虚拟路由器冗余协议)的缩写,VRRP 出现的目的就是为了解决静态路由单点故障的问题,它能够保证当个别节点宕机时,整个网络可以不间断地运行。

所以,keepalived 一方面具有配置管理 LVS 的功能,同时还具有对 LVS 下面节点进行健康检查的功能,另一方面也可实现系统网络服务的高可用。

3. keepalived 服务重要功能

- 管理 LVS 负载均衡软件

- 支持故障自动切换(Failover)

- 实现 LVS 集群中节点的健康检查(Health Checking)

- 实现 LVS 负载调度器、节点服务器的高可用性(HA)

一般企业集群需要满足的三个特点:负载均衡、健康检查、故障切换,使用 LVS + Keepalived 完全可以满足需求。

4. keepalived 高可用故障切换转移原理

keepalived 高可用服务对集群之间的故障切换转移,是通过 VRRP(虚拟路由器冗余协议)来实现的。

在 keepalived 服务正常工作时,主(Master)节点会不断地向备(Backup)节点发送(多播的方式)心跳消息,用以告诉备节点自己还活看,当主节点发生故障时,就无法发送心跳消息,备节点也就因此无法继续检测到来自主节点的心跳了,于是调用自身的接管程序,接管主节点的 IP 资源及服务。而当主节点恢复时,备节点又会释放主节点故障时自身接管的 IP 资源及服务,恢复到原来的备用角色。

5. keepalived 体系主要模块及其作用

| keepalived 的主要模块 | 作用 |

|---|---|

| core 模块 | 为 keepalived 的核心,负责主进程的启动、维护及全局配置文件的加载和解析 |

| vrrp 模块 | 是来实现 VRRP 协议的 |

| check 模块 | 负责健康检查,常见的方式有端口检查及 UR L检查 |

6. 使用 keepalived 实现双机热备

- 基于 VRRP 协议的热备方式,keepalived 可以用作服务器的故障切换,每个热备组可以有多台服务器。当然,最常用的还是双机热备。

- 在双击热备方案中,故障切换主要针对虚拟 IP 地址的漂移来实现,因此可以适用于各种应用服务器(Web、FTP、Mail、SSH、DNS…)

- 其中主、备服务器都需安装 keepalived

二、LVS + DR + Keepalived 高可用集群构建

1. 集群概述

- keepalived 的设计目标是构建高可用的 LVS 负载均衡集群,可以调用 ipvsadm 工具来创建虚拟服务器、管理服务器池,而不仅仅用作双机热备

- 使用 keepalived 构建 LVS 集群更加简便易用,主要优势在于:对 LVS 负载调度器实现热备切换,提高可用性;对服务器池中的节点进行健康检查,自动移除失效节点,恢复后再重新加入

- 案列将以 DR 模式的 LVS 集群为基础,增加一台从负载调度器,使用 keepalived 实现主、从调度器的热备,搭建兼有负载均衡、高可用性两种能力的 LVS 集群架构

- 使用 keepalived 构建 LVS 集群时,也需要用到 ipvsadm 管理工具,但大部分工作会由 keepalived 自动完成,不需要手动执行 ipvsadm (除了查看和监控集群以外)

- 架构图示例

3. 案例配置

| 服务器 | IP |

|---|---|

| 主 DR 服务器 | 192.168.10.20 |

| 从 DR 服务器 | 192.168.10.60 |

| VIP | 192.168.10.25 |

| Web 服务器 1 | 192.168.10.30 |

| Web 服务器 2 | 192.168.10.40 |

| NFS 服务器 | 192.168.10.50 |

| Win10 客户端 | 192.168.10.85 |

keepalived 高可用集群的构建基于 LVS-DR 模式,LVS-DR 配置参考:

LVS 负载均衡集群 - 直接路由模式(LVS-DR)

只需要在 LVS-DR 模式的基础上加一台从 DR 调度器(最好与主 DR 配置相同)

4. 正式部署

(1) 从负载调度器配置

systemctl stop firewalld.service && systemctl disable firewalld.service setenforce 0 modprobe ip_vs cat /proc/net/ip_vs yum install -y ipvsadm cd /etc/sysconfig/network-scripts/ && cp ifcfg-ens33 ifcfg-ens33:0 echo > /etc/sysconfig/network-scripts/ifcfg-ens33:0 cat > /etc/sysconfig/network-scripts/ifcfg-ens33:0 <<EOF DEVICE=ens33:0 ONBOOT=yes IPADDR=192.168.10.25 NETMASK=255.255.255.255 EOF ifup ens33:0 #lvs_01 已经有 VIP 了,直接用 ifup 会执行失败 systemctl restart network ifup ens33:0 #再次执行 ip a #确认一下 ens33:0 是否生效 cat >> /etc/sysctl.conf <<EOF net.ipv4.ip_forward = 0 net.ipv4.conf.all.send_redirects = 0 net.ipv4.conf.default.send_redirects = 0 net.ipv4.conf.ens33.send_redirects = 0 EOF sysctl -p ipvsadm-save > /etc/sysconfig/ipvsadm systemctl start ipvsadm && systemctl enable ipvsadm ipvsadm -C ipvsadm -A -t 192.168.10.25:80 -s rr ipvsadm -a -t 192.168.10.25:80 -r 192.168.10.30:80 -g ipvsadm -a -t 192.168.10.25:80 -r 192.168.10.40:80 -g ipvsadm ipvsadm -ln (2) 主-从负载调度器安装配置 keepalived

keepalived 的配置大致一样,只是名称和优先级有所差别,注意注释说明,逐个修改

yum -y install keepalived #安装软件包 cd /etc/keepalived/ cp keepalived.conf keepalived.conf.bak #备份 vim keepalived.conf #配置文件只需要从 global_defs 开始的内容,上面无用的配置也清掉 global_defs {

#定义全局参数 #第10行,邮件服务指向本地 smtp_server 127.0.0.1 #第12行,指定服务器(路由器)的名称,主备服务器名称须不同,主为 LVS_01,备为 LVS_02 router_id LVS_01 } vrrp_instance VI_1 {

#定义 VRRP 热备实例参数 #20行,指定热备状态,主为 MASTER,备为 BACKUP state MASTER #21行,指定承载 vip 地址的物理接口 interface ens33 #第22行,指定虚拟路由器的 ID 号,每个热备组保持一致 virtual_router_id 10 #第23行,指定优先级,数值越大优先级越高,主为 100,备为 99 priority 100 advert_int 1 #通告间隔秒数(心跳频率) authentication {

#定义认证信息,每个热备组保持一致 auth_type PASS #认证类型 #第27行,指定验证密码,主备服务器保持一致 auth_pass } virtual_ipaddress {

#指定群集vip地址 192.168.10.25 } } #第34行,指定虚拟服务器地址(VIP)、端口,定义虚拟服务器和 Web 服务器池参数 virtual_server 192.168.10.25 80 {

delay_loop 6 #健康检查的间隔时间(秒) lb_algo rr #指定调度算法,轮询(rr) #第37行,指定群集工作模式,直接路由(DR) lb_kind DR persistence_timeout 50 #连接保持时间(秒) protocol TCP #应用服务采用的是 TCP协议 #第41行,指定第一个Web节点的地址、端口 real_server 192.168.10.30 80 {

weight 1 #节点的权重 #第43行,添加以下健康检查方式,删掉不需要的配置 TCP_CHECK {

connect_port 80 #添加检查的目标端口 connect_timeout 3 #添加连接超时(秒) nb_get_retry 3 #添加重试次数 delay_before_retry 3 #添加重试间隔 } } real_server 192.168.10.40 80 {

#添加第二个 Web 节点的地址、端口 weight 1 TCP_CHECK {

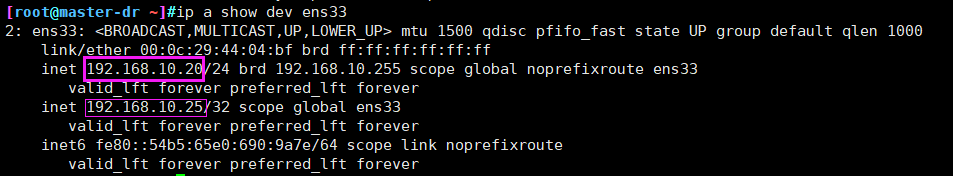

connect_port 80 connect_timeout 3 nb_get_retry 3 delay_before_retry 3 } } } #可删除后面多余的网段 systemctl start keepalived && systemctl enable keepalived #两个负载调度器开启 keepalived 服务 ip addr show dev ens33 #查看虚拟网卡 vip 主 DR 网卡信息

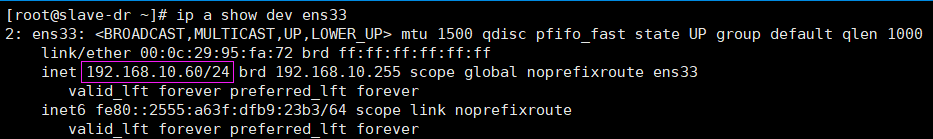

从 DR 网卡信息

我们可以看到,主负载调度节点是有 VIP 的,从节点没有,说明 VIP 目前固定在 LVS_01。

(3) Windows 10 测试访问

- 在客户机的浏览器中,能够通过 LVS + Keepalived 群集的 VIP 地址正常访问 Web 页面内容

- 当主、从调度器任何一个失效时,Web 站点仍然可以访问(可能需要刷新或者重新打开浏览器)

- 只要有两台及以上的真实服务器可用,就可以实现访问量的负载均衡

(4) 关掉 lvs_01 keepalived 服务测试访问

在主负载调度器上

yum -y stop keepalived 首先 VIP 会漂移到 lvs_02

浏览器访问测试,负载均衡仍然生效,高可用负载均衡集群搭建成功

重启 lvs_01 keepalived 服务,VIP 漂移回 lvs_01

- 附

上面 主/从 配置注释太多,这里放个配置纯净版的,没有注释

根据自己的 IP 、网卡名、想要设置的密码…进行修改

(1) lvs_01

我们实验是接着 LVS-DR 做的,前面配置过了 lvs_01 ,这里只需要配置 keepalived

yum -y install keepalived cd /etc/keepalived/ && cp -a keepalived.conf keepalived.conf.bak echo > /etc/keepalived/keepalived.conf cat > /etc/keepalived/keepalived.conf<<EOF global_defs { router_id lvs_01 } vrrp_instance vi_1 { state MASTER interface ens33 virtual_router_id 51 priority 110 advert_int 1 authentication { auth_type PASS auth_pass 6666 } virtual_ipaddress { 192.168.10.25 } } virtual_server 192.168.10.25 80 { lb_algo rr lb_kind DR persistence_timeout 6 protocol TCP real_server 192.168.10.30 80 { weight 1 TCP_CHECK { connect_port 80 connect_timeout 3 nb_get_retry 3 delay_before_retry 3 } } real_server 192.168.10.40 80 { weight 1 TCP_CHECK { connect_port 80 connect_timeout 3 nb_get_retry 3 delay_before_retry 3 } } } EOF systemctl start keepalived && systemctl enable keepalived ip a show dev ens33 (2) lvs_02

lvs_02 是新加入的节点,lvs_01 的所有操作都要做一遍,只有在配置 keepalived 的时候有一些差别 systemctl stop firewalld.service && systemctl disable firewalld.service setenforce 0 modprobe ip_vs cat /proc/net/ip_vs yum install -y ipvsadm cd /etc/sysconfig/network-scripts/ && cp ifcfg-ens33 ifcfg-ens33:0 echo > /etc/sysconfig/network-scripts/ifcfg-ens33:0 cat > /etc/sysconfig/network-scripts/ifcfg-ens33:0 <<EOF DEVICE=ens33:0 ONBOOT=yes IPADDR=192.168.10.25 NETMASK=255.255.255.255 EOF ifup ens33:0 systemctl restart network ifup ens33:0 ip a show dev ens33 cat >> /etc/sysctl.conf <<EOF net.ipv4.ip_forward = 0 net.ipv4.conf.all.send_redirects = 0 net.ipv4.conf.default.send_redirects = 0 net.ipv4.conf.ens33.send_redirects = 0 EOF sysctl -p ipvsadm-save > /etc/sysconfig/ipvsadm systemctl start ipvsadm && systemctl enable ipvsadm ipvsadm -C ipvsadm -A -t 192.168.10.25:80 -s rr ipvsadm -a -t 192.168.10.25:80 -r 192.168.10.30:80 -g ipvsadm -a -t 192.168.10.25:80 -r 192.168.10.40:80 -g ipvsadm ipvsadm -ln yum -y install keepalived cd /etc/keepalived/ && cp -a keepalived.conf keepalived.conf.bak echo > /etc/keepalived/keepalived.conf cat > /etc/keepalived/keepalived.conf<<EOF global_defs { router_id lvs_02 } vrrp_instance vi_1 { state BACKUP interface ens33 virtual_router_id 51 priority 100 advert_int 1 authentication { auth_type PASS auth_pass 6666 } virtual_ipaddress { 192.168.10.25 } } virtual_server 192.168.10.25 80 { lb_algo rr lb_kind DR persistence_timeout 6 protocol TCP real_server 192.168.10.30 80 { weight 1 TCP_CHECK { connect_port 80 connect_timeout 3 nb_get_retry 3 delay_before_retry 3 } } real_server 192.168.10.40 80 { weight 1 TCP_CHECK { connect_port 80 connect_timeout 3 nb_get_retry 3 delay_before_retry 3 } } } EOF systemctl start keepalived && systemctl enable keepalived ip a show dev ens33 今天的分享到此就结束了,感谢您的阅读,如果确实帮到您,您可以动动手指转发给其他人。

上一篇

已是最后文章

下一篇

已是最新文章