Python爬虫从入门到精通——爬虫基础:HTTP基本原理

Hi,大家好,我是编程小6,很荣幸遇见你,我把这些年在开发过程中遇到的问题或想法写出来,今天说一说Python爬虫从入门到精通——爬虫基础:HTTP基本原理,希望能够帮助你!!!。

分类目录:《Python爬虫从入门到精通》总目录

在本文中,我们会详细了解HTTP的基本原理,了解在浏览器中敲入URL到获取网页内容之间发生了什么。了解了这些内容,有助于我们进一步了解爬虫的基本原理。

URI和URL

URI的全称为Uniform Resource ldentifier,即统一资源标志符,URL的全称为Universal Resource Locator,即统一资源定位符。

举例来说,https://github.com/favicon.ico是GitHub的网站图标链接,它是一个URL,也是一个URI。即有这样的一个图标资源,我们用URL/URI来唯一指定了它的访问方式,这其中包括了访问协议https、访问路径(即根目录)和资源名称favicon.ico。通过这样一个链接,我们便可以从互联网上找到这个资源,这就是URI/URL。

URL是URI的子集,也就是说每个URL都是URI,但不是每个URI都是URL。URI还包括一个子类叫作URN,它的全称为Universal Resource Name,即统一资源名称。URN只命名资源而不指定如何定位资源,比如urn:isbn:0451450523指定了一本书的ISBN,可以唯一标识这本书,但是没有指定到哪里定位这本书,这就是URN。但是在目前的互联网中,URN用得非常少,所以几乎所有的URI都是URL,一般的网页链接我们既可以称为URL,也可以称为URI。

URL也不是随便写的,它也是需要遵循一定格式规范的,基本的组成格式如下:

scheme:// [username: password@]hostname[ :port][/path][;parameters][ ?query][#fragment]

其中,中括号包括的内容代表非必要部分,比如https://www.baidu.com这个URL,这里就只包含了scheme和hostname两部分,没有port、path、parameters、query、fragment。这里我们分别介绍一下几部分代表的含义和作用:

scheme:协议,常用的协议有http、https、ftp等,另外scheme也被常称作protocol,二者都代表协议的意思。username: password@:用户名和密码。在某些情况下URL需要提供用户名和密码才能访问,这时候可以把用户名和密码放在host前面。比如https://sst3.scrape.center这个URL需要用户名和密码才能访问,直接写为htps://admin:admin@ssr3.scrape.center则可以直接访问。hostname:主机地址。可以是域名或IP地址,比如https://www.baidu.com这个URL中的hostname就是www.baidu.com,这就是百度的二级域名。比如https://8.8.8.8这个URL中的hostname就是8.8.8.8,它是一个IP地址。port:端口。这是服务器设定的服务端口,比如https://8.8.8.8:12345这个URL中的端口就是12345。但是有些URL中没有端口信息,这是使用了默认的端口。http协议的默认端口是80,https协议的默认端口是443。所以https://www.baidu.com其实相当于https:/www.baidu.com:443,而http://www.baidu.com其实相当于http://www.baidu com:80。path:路径。指的是网络资源在服务器中的指定地址,比如https://github.com/favicon.ico中的path就是favicon.ico, 指的是访问GitHub根目录下的favicon.ico。parameters:参数。用来指定访问某个资源时的附加信息,比如http://8.8.8.8:12345/hello;user中的user就是parameters。但是parameters现在用得很少,所以目前很多人会把该参数后面的query部分称为参数,甚至把parameters和query混用。严格意义上来说,parameters是分号(;)后面的内容。query:查询。用来查询某类资源,如果有多个查询,则用&隔开。query其实非常常见,比如https://www.baidu.com/s?wd=nba&ie=utf-8,其中的query部分就是wd=nba&ie=utf-8,这里指定了wd是nba,ie是utf-8。由于query比刚才所说的parameters使用频率高很多,所以平时我们见到的参数、GET请求参数、parameters、params等称呼多数情况指代的也是query。fragment:片段。它是对资源描述的部分补充,可以理解为资源内部的书签。目前它有两个主要的应用,一个是用作单页面路由,比如现代前端框架Vue、React都可以借助它来做路由管理;另外一个是用作HTML锚点,用它可以控制一个页面打开时自动下滑滚动到某个特定的位置。

超文本

超文本的英文名称为hypertext,我们在浏览器里看到的网页就是超文本解析而成的,其网页源代码是一系列HTML代码,里面包含了一系列标签,比如img显示图片,p指定显示段落等。浏览器解析这些标签后,便形成了我们平常看到的网页,而网页的源代码HTML就可以称作超文本。

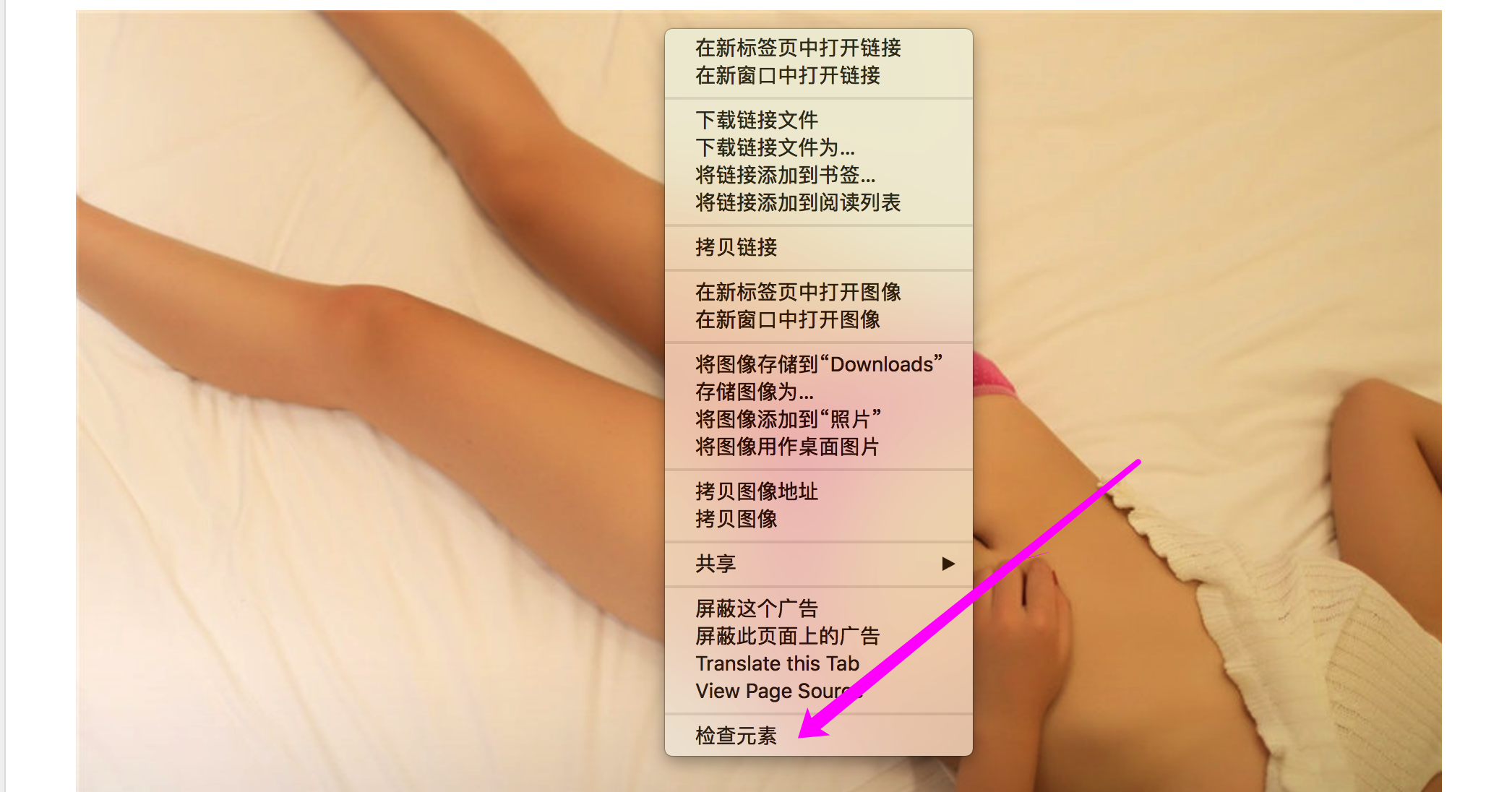

例如,我们在Chrome浏览器里面打开任意一个页面,如淘宝首页,右击任一地方并选择“检查”项(或者直接按快捷键F12),即可打开浏览器的开发者工具,这时在Elements选项卡即可看到当前网页的源代码,这些源代码都是超文本。

HTTP和HTTPS

刚才我们了解了URL的基本构成,其支持的协议有很多,比如http、https、ftp、sftp、smb等。在爬虫中,我们抓取的页面通常是基于http或https协议的,因此这里首先了解一下这两个协议的含义。

HTTP的全称是Hypertext Transfer Protocol,中文名为超文本传输协议,其作用是把超文本数据从网络传输到本地浏览器,能够保证高效而准确地传输超文本文档。HTTP是由万维网协会(World Wide Web Consortium)和 InternetT作小组 IETF(Internet Engineering Task Force)合作制定的规范,目前被人们广泛使用的是HTTP 1.1版本,当然,现在也有不少网站支持HTTP 2.0。

| 版本 | 产生时间 | 主要特点 | 发展现状 |

|---|---|---|---|

| HTTP 0.9 | 1991年 | 不涉及数据包传输,规定客户端和服务器之间的通信格式,只能使用GET请求 | 没有作为正式的标准 |

| HTTP 1.0 | 1996年 | 传输内容格式不限制,增加PUT、PATCH、HEAD、OPTIONS、DELETE命令 |

正式作为标准 |

| HTTP 1.1 | 1997年 | 持久连接(长连接)、节约带宽,HOST域、管道机制、分块传输编码 | 正式作为标准并广泛使用 |

| HTTP 2.0 | 2015年 | 多路复用、服务器推送、头信息压缩、二进制协议等 | 逐渐覆盖市场 |

HTTPS 的全称是Hypertext Transfer Protocol over Secure Socket Layer,是以安全为目标的 HTTP通道,简单讲就是HTTP的安全版,即在HTTP下加入SSL层,简称HTTPS。

HTTPS的安全基础是SSL,因此通过该协议传输的内容都是经过SSL加密的,SSL的主要作用有以下两种。

- 建立一个信息安全通道,保证数据传输的安全性。

- 确认网站的真实性。凡是使用了HTTPS协议的网站,都可以通过单击浏览器地址栏的锁头标志来查看网站认证之后的真实信息,此外还可以通过CA机构颁发的安全签章来查询。

现在有越来越多的网站和App朝着HTTPS的方向发展:

- 苹果公司强制所有iOS App在2017年1月1日前全部改为使用HTTPS加密,否则App无法在应用商店上架。

- 谷歌从2017年1月推出的Chrome 56开始,对未进行HTTPS加密的网址亮出风险提示,即在地址栏的显著位置提醒用户“此网页不安全”。

- 腾讯微信小程序的官方需求文档要求后台使用HTTPS请求进行网络通信,不满足条件的域名和协议无法正常请求。

HTTPS已然是大势所趋。HTTP和HTTPS协议都属于计算机网络中的应用层协议,其下层是基于TCP协议实现的,TCP协议属于计算机网络中的传输层协议,包括建立连接时的三次握手和断开时的四次挥手等过程。但本文主要讲的是网络爬虫相关知识,主要爬取的是HTTP/HTTPS协议相关的内容,因此这里就不对TCP、IP等内容展开深入讲解了,感兴趣的读者可以搜索相关资料了解下。

HTTP请求过程

我们在浏览器中输入一个URL,回车之后便会在浏览器中观察到页面内容。实际上,这个过程是浏览器向网站所在的服务器发送了一个请求,网站服务器接收到这个请求后进行处理和解析,然后返回对应的响应,接着传回给浏览器。响应里包含了页面的源代码等内容,浏览器再对其进行解析,便将网页呈现了出来。

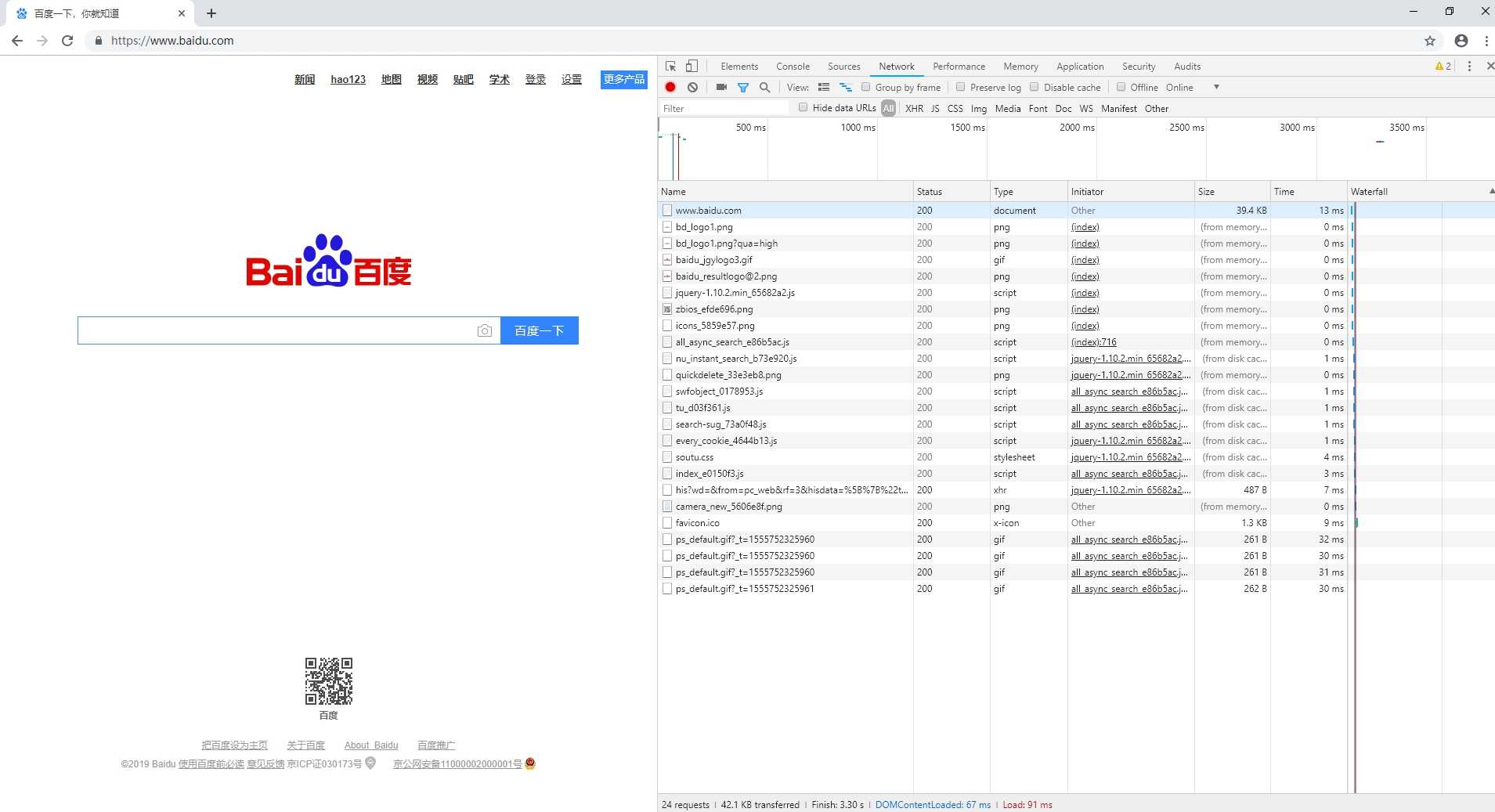

此处客户端即代表我们自己的PC或手机浏览器,服务器即要访问的网站所在的服务器。为了更直观地说明这个过程,这里用Chrome浏览器的开发者模式下的Network监听组件来做下演示,它可以显示访问当前请求网页时发生的所有网络请求和响应。打开Chrome浏览器,右击并选择“检查”项,即可打开浏览器的开发者工具。这里访问百度http://www.baidu.com/,输入该URL后回车,观察这个过程中发生了怎样的网络请求。可以看到,在Network页面下方出现了一个个的条目,其中一个条目就代表一次发送请求和接收响应的过程。

我们先观察第一个网络请求,即www.baidu.com。其中各列的含义如下:

- 第一列Name:请求的名称,一般会将URL的最后一部分内容当作名称。

- 第二列Status:响应的状态码,这里显示为200,代表响应是正常的。通过状态码,我们可以判断发送了请求之后是否得到了正常的响应。

- 第三列Type:请求的文档类型。这里为document,代表我们这次请求的是一个HTML文档,内容就是一些HTML代码。

- 第四列Initiator:请求源。用来标记请求是由哪个对象或进程发起的。

- 第五列Size:从服务器下载的文件和请求的资源大小。如果是从缓存中取得的资源,则该列会显示from cache。

- 第六列Time:发起请求到获取响应所用的总时间。

- 第七列Waterfal:网络请求的可视化瀑布流。

点击这个条目,即可看到更详细的信息。首先是General部分,Request URL为请求的URL,Request Method为请求的方法,Status Code为响应状态码,Remote Address为远程服务器的地址和端口,Referer Policy为Referrer判别策略。再继续往下,可以看到,有Response Headers和Request Headers,这分别代表响应头和请求头。请求头里带有许多请求信息,例如浏览器标识、Cookies、Host等信息,这是请求的一部分,服务器会根据请求头内的信息判断请求是否合法,进而作出对应的响应。图中看到的Response Headers就是响应的一部分,例如其中包含了服务器的类型、文档类型、日期等信息,浏览器接受到响应后,会解析响应内容,进而呈现网页内容。下面我们分别来介绍一下请求和响应都包含哪些内容。

请求

请求,由客户端向服务端发出,可以分为4部分内容:请求方法(Request Method)、请求的网址(Request URL)、请求头(Request Headers)、请求体(Request Body)。

请求方法

常见的请求方法有两种:GET和POST。在浏览器中直接输入URL并回车,这便发起了一个GET请求,请求的参数会直接包含到 URL里。例如,在百度中搜索Python,这就是一个GET请求,链接为https://www.baidu.com/s?wd=Python,其中URL中包含了请求的参数信息,这里参数wd表示要搜寻的关键字。POST请求大多在表单提交时发起。比如,对于一个登录表单,输入用户名和密码后,点击“登录”按钮,这通常会发起一个POST请求,其数据通常以表单的形式传输,而不会体现在URL中。

GET和POST请求方法有如下区别。

- GET请求中的参数包含在URL里面,数据可以在URL中看到,而POST请求的URL不会包含这些数据,数据都是通过表单形式传输的,会包含在请求体中。

- GET请求提交的数据最多只有1024字节,而POST方式没有限制。

一般来说,登录时,需要提交用户名和密码,其中包含了敏感信息,使用GET方式请求的话,密码就会暴露在URL里面,造成密码泄露,所以这里最好以POST方式发送。上传文件时,由于文件内容比较大,也会选用POST方式。

我们平常遇到的绝大部分请求都是GET或POST请求,另外还有一些请求方法,如

GET、HEAD、POST、PUT、DELETE、OPTIONS、CONNECT、TRACE等。

请求的网址

请求的网址,即统一资源定位符URL,它可以唯一确定我们想请求的资源。

请求头

请求头,用来说明服务器要使用的附加信息,比较重要的信息有Cookie、Referer、User-Agent等。

- Accept:请求报头域,用于指定客户端可接受哪些类型的信息。

- Accept-Language:指定客户端可接受的语言类型。

- Accept-Encoding:指定客户端可接受的内容编码。

- Host:用于指定请求资源的主机IP和端口号,其内容为请求URL的原始服务器或网关的位置。从HTTP1.1版本开始,请求必须包含此内容。

- Cookie:也常用复数形式Cookies,这是网站为了辨别用户进行会话跟踪而存储在用户本地的数据。它的主要功能是维持当前访问会话。例如,我们输入用户名和密码成功登录某个网站后,服务器会用会话保存登录状态信息,后面我们每次刷新或请求该站点的其他页面时,会发现都是登录状态,这就是Cookies的功劳。Cookies里有信息标识了我们所对应的服务器的会话,每次浏览器在请求该站点的页面时,都会在请求头中加上Cookies并将其发送给服务器,服务器通过Cookies识别出是我们自己,并且查出当前状态是登录状态,所以返回结果就是登录之后才能看到的网页内容。

- Referer:此内容用来标识这个请求是从哪个页面发过来的,服务器可以拿到这一信息并做相应的处理,如做来源统计、防盗链处理等。

- User-Agent:简称UA,它是一个特殊的字符串头,可以使服务器识别客户使用的操作系统及版本、浏览器及版本等信息。在做爬虫时加上此信息,可以伪装为浏览器;如果不加,很可能会被识别出为爬虫。

- Content-Type:也叫互联网媒体类型(Internet Media Type)或者MIME类型,在HTTP协议消息头中,它用来表示具体请求中的媒体类型信息。例如,texthtml代表HTML格式,image/gif代表GIF图片,application/json代表JSON类型等。

因此,请求头是请求的重要组成部分,在写爬虫时,大部分情况下都需要设定请求头。

请求体

请求体一般承载的内容是POST请求中的表单数据,而对于GET请求,请求体则为空。登录之前,我们填写了用户名和密码信息,提交时这些内容就会以表单数据的形式提交给服务器,此时需要注意Request Headers 中指定Content-Type为application/x-www-form-urlencoded。只有设置Content-Type为application/x-www-form-urlencoded,才会以表单数据的形式提交。另外,我们也可以将Content-Type 设置为application/json来提交JSON数据,或者设置为multipart/form-data来上传文件。

在爬虫中,如果要构造POST请求,需要使用正确的Content-Type,并了解各种请求库的各个参数设置时使用的是哪种Content-Type,不然可能会导致POST提交后无法正常响应。

响应

响应,由服务端返回给客户端,可以分为三部分:响应状态码(Response Status Code)、响应头(Response Headers)和响应体(Response Body)。

响应状态码

响应状态码表示服务器的响应状态,如200代表服务器正常响应,404代表页面未找到,500代表服务器内部发生错误。在爬虫中,我们可以根据状态码来判断服务器响应状态,如状态码为200,则证明成功返回数据,再进行进一步的处理,否则直接忽略。

响应头

响应头包含了服务器对请求的应答信息,如Content-Type、Server、Set-Cookie等。下面简要说明一些常用的头信息。

- Date:标识响应产生的时间。

- Last-Modified:指定资源的最后修改时间。口Content-Encoding:指定响应内容的编码。口Server:包含服务器的信息,比如名称、版本号等。

- Content-Type:文档类型,指定返回的数据类型是什么,如texthtml代表返回HTML文档,application/x-javascript则代表返回JavaScript文件,image/jpeg则代表返回图片。

- Set-Cookie:设置Cookies。响应头中的Set-Cookie告诉浏览器需要将此内容放在Cookies中,下次请求携带 Cookies请求。

- Expires:指定响应的过期时间,可以使代理服务器或浏览器将加载的内容更新到缓存中。如果再次访问时,就可以直接从缓存中加载,降低服务器负载,缩短加载时间。

响应体

最重要的当属响应体的内容了。响应的正文数据都在响应体中,比如请求网页时,它的响应体就是网页的HTML代码;请求一张图片时,它的响应体就是图片的二进制数据。我们做爬虫请求网页后,要解析的内容就是响应体。

今天的分享到此就结束了,感谢您的阅读,如果确实帮到您,您可以动动手指转发给其他人。