python网络爬虫:批量爬取图片「建议收藏」

Hi,大家好,我是编程小6,很荣幸遇见你,我把这些年在开发过程中遇到的问题或想法写出来,今天说一说python网络爬虫:批量爬取图片「建议收藏」,希望能够帮助你!!!。

本文主要运用BeautifulSoup库进行图片网站的图片爬取.

python版本:3.8.5, 爬取时间:2022/8/3

共分三大步:

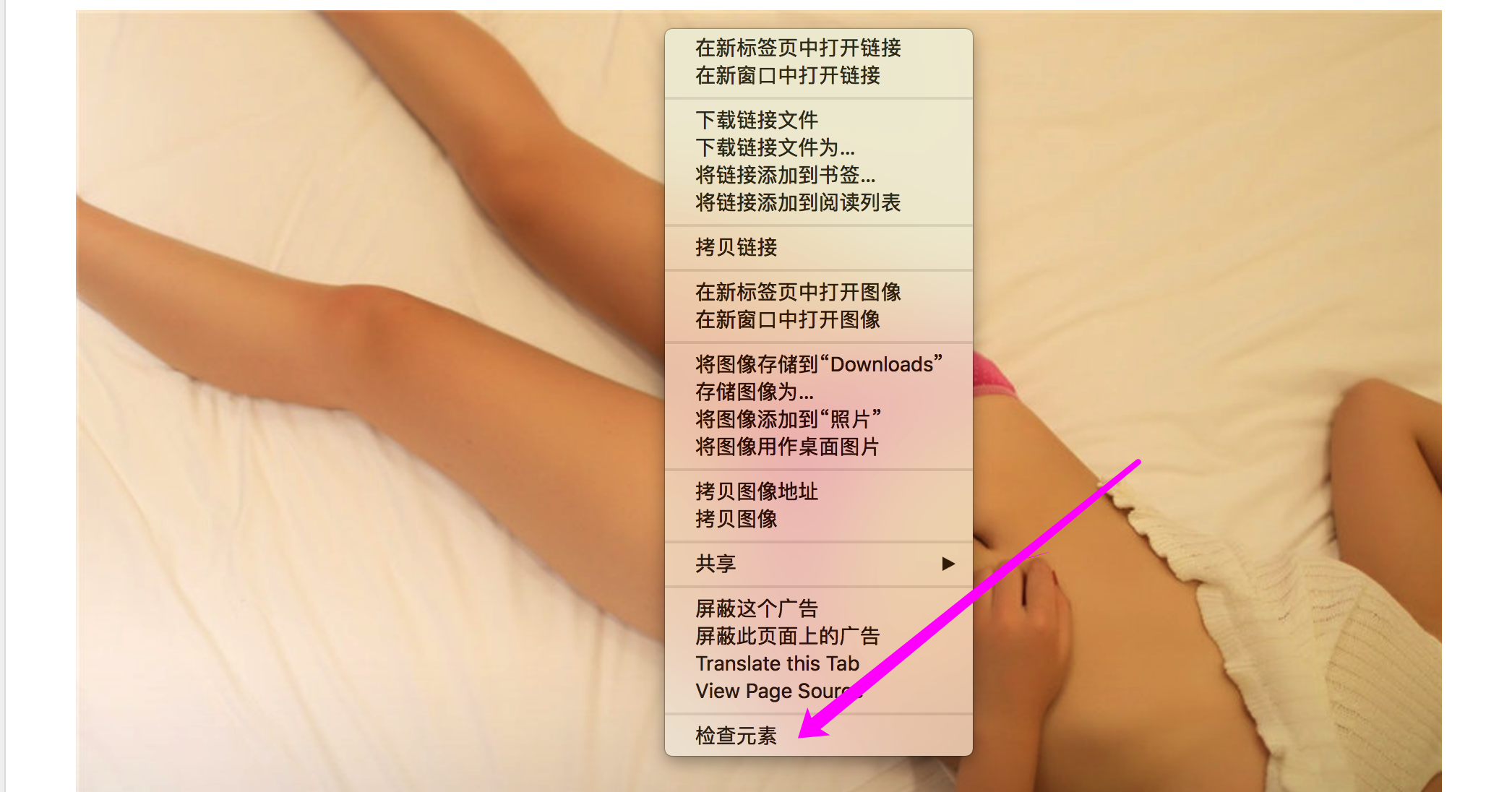

第一大步:找个简单点的图片网站

第二大步:获取网站的源代码,从中获取图片地址

第三大步:下载图片

代码如下

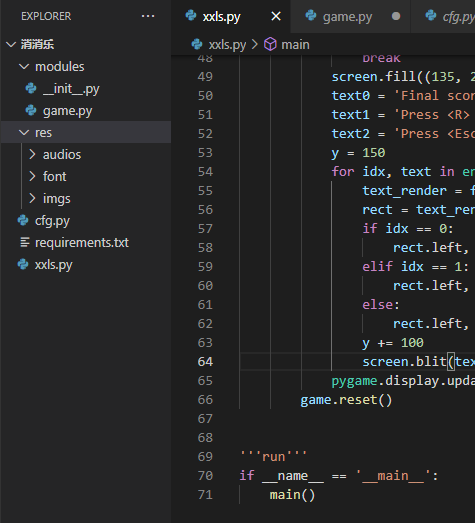

代码1-23行

代码24-33行

运行结果

代码所在行的6个小小知识点:

第7行: 请求头里面的User-Agent,简称UA,可以使服务器识别客户端使用的操作系统-版本,以及浏览器-版本 等信息. 加上这个伪装成浏览器对服务器发出请求.要不然有一部分服务器识别出是脚本发出的请求就会拒绝响应.

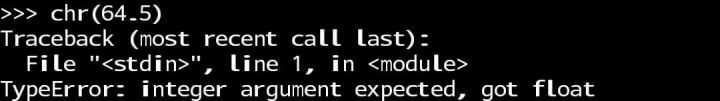

第11行: 我们自己用的,默认是utf-8编码方式,有的网页不是这种,就需要编码. 查看网页使用的哪种编码方式,看charset后面的字符.

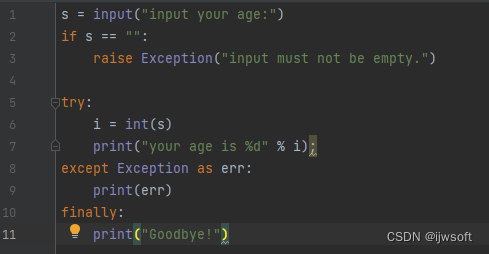

第13行: 不加入html.parser参数,BS库就不知道需要解析哪种数据文本,虽然会默认解析html,但BS还是会在运行的时候提醒你,如下图. 有html.parser就是告诉BS解析html文本,它也就不会提醒你了.

BS库警告的内容第1-2行的红色内容就是

第16行: html页面标签中的属性名称是class时,因为class是python中的关键字,直接使用可能会发生错误,所以可以写成class_形式,或者跟代码中一样,把属性名称和属性弄成字典并且字典名为attrs(注意attrs名称是固定的)

观察发现源代码中的标签,唯一属性,图片地址

第30行,导入time模块后,结合.sleep就设置了下载的时间间隔为1秒.要是单位时间内下载量过大,容易把简易网站的服务器弄崩溃.

第33行,这是跟第30行一样重要的东西了.有时候我们编写完爬虫文件后,要关闭pycharm时,它会提醒我们某某文件正在运行,要关闭吗? 原因就是某些文件里面的爬虫程序还在向服务器不断的发送请求,而这些请求不会自动关闭,所以我们仅仅是出于单次学习目的的话,养成在代码结尾写上

"响应".close()

的习惯.

结尾: 一些网站的反爬手段更新极快,且增强了数据保护意识,导致网络上的爬虫教学资源大多数都没法用了.警惕智商税,且行且珍惜.